提升AI體驗!AMD Ryzen AI 300系列處理器釋放消費級LLM巔峰效能

LM Studio以llama.cpp為基礎,是一個便於部署語言模型的框架,無需依賴性(dependencies)即可使用CPU或GPU進行加速,支援基於x86 CPU的AVX2指令集加速。透過AMD的Ryzen AI技術,使用者在x86筆記型電腦上運行LLM應用程式,如LM Studio,體驗領先業界的效能。特別是對於記憶體速度高度敏感的LLM,AMD Ryzen AI展現出顯著的效能優勢。

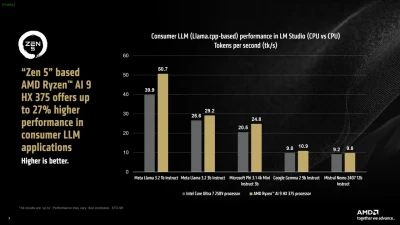

對比測試中,儘管Intel筆記型電腦的RAM速度達8533 MT/s,優於AMD的7500 MT/s,AMD Ryzen AI 9 HX 375處理器在每秒token生成速度(tokens per second,LLM每秒生成並輸出的單位,大致相當於螢幕顯示的字數)方面仍然比競爭對手快出27%。

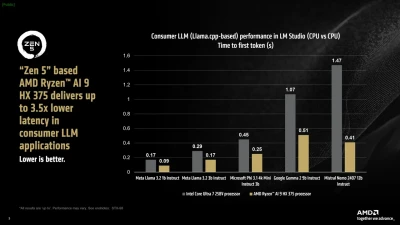

針對Meta Llama 3.2 1b Instruct(4-bit量化)模型,AMD Ryzen™ AI 9 HX 375處理器每秒生成速度達50.7 token。另一個效能指標「輸出首個token的時間」(time to first token),則測量從提交提示(prompt)到模型開始生成token的延遲。測試顯示,在大型模型中,AMD Ryzen AI HX 375處理器比同級競爭處理器速度快出高達3.5倍。

AMD Ryzen AI處理器中整合的三個加速器各有特定的工作負載專業化。基於XDNA 2架構的NPU在執行Copilot+工作負載時提供高效能和低功耗,而CPU則負責覆蓋範圍廣泛的工具和框架相容性。內顯(iGPU)則根據需求負責AI運算的加速。

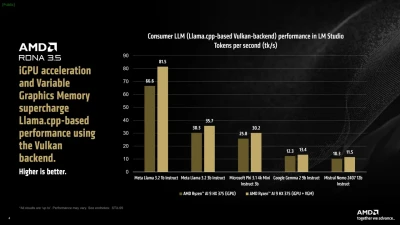

LM Studio中提供的llama.cpp版本支援無廠商依賴性的Vulkan API,可根據硬體和驅動程式最佳化實現顯著加速。與僅用CPU的模式相比,啟用GPU offload後Meta Llama 3.2 1b Instruct模型的效能平均提升31%。對於較大模型Mistral Nemo 2407 12b Instruct,token生成階段因頻寬限制而平均提升5.1%。

在使用基於Vulkan的llama.cpp版本並啟用GPU offload後,LM Studio中運行的模型整體效能顯著提升。相比之下,Intel Core Ultra 7 258v處理器在LM Studio中未達同等效能。因此,為確保測試公平性,此組比較未將Intel處理器的GPU-offload效能納入評比。

AMD Ryzen AI 300系列處理器包含可變顯示記憶體(VGM)功能,可將512 MB的專用記憶空間擴展至高達系統RAM容量的75%,對於記憶體敏感的應用程式提供連續的記憶體支援。在啟用VGM(16GB)模式下,Meta Llama 3.2 1b Instruct模型的效能提升達22%,而整體速度相比傳統CPU模式增長60%。此外,對於Mistral Nemo 2407 12b Instruct等大型模型,iGPU加速結合VGM模式後效能可提升17%。

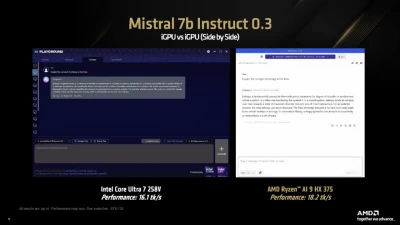

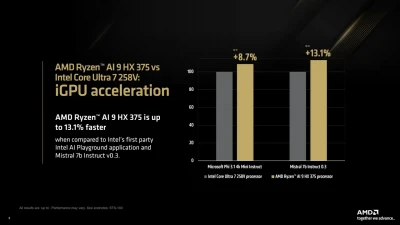

為進一步比較Intel平台效能,我們在Intel AI Playground應用程式(基於IPEX-LLM和LangChain)中測試了Mistral 7b Instruct v0.3和Microsoft Phi 3.1 Mini Instruct模型。結果顯示,經過量化後的AMD Ryzen AI 9 HX 375處理器在Phi 3.1模型上的生成速度比競爭對手快8.7%,而在Mistral 7b Instruct 0.3模型上則快13%。

點擊閱讀下一則新聞

點擊閱讀下一則新聞

鄭重聲明:本文版權歸原作者所有,轉載文章僅為傳播信息之目的,不構成任何投資建議,如有侵權行為,請第一時間聯絡我們修改或刪除,多謝。

標題:提升AI體驗!AMD Ryzen AI 300系列處理器釋放消費級LLM巔峰效能

地址:https://www.twnewsletter.com/article/55302.html